自分ですぐコピペしたい時もあるため、結果のコードから掲載します。

<head>タグの中に設定してください。

ページ検索除外の関連一括設定

<meta name=”robots” content=”noindex,nofollow,noarchive”>

インデックスからの除外のみを行う

<meta name=”robots” content=”noindex”>

公開前の”緩い”アクセス制限であれば、最初のコードで良いと思います。

meta設定による検索制限は、パスワードを必要とするような用途には向かきません。

使い方を確認して正しく利用しましょう。

記事のポイント

- ページを検索結果に表示しないよう設定できる

- 使ってはいけないシーンを確認し、正しく運用ができるようになる

robots(クローラ命令)の用途と使い方

robotsでは、Googleなどの検索結果を収集するボット(クローラ)に対して命令することができます。

noindex(=検索結果に表示させない)が代表的です。

ちなみに、robotsを利用して検索順位を上げさせることはできません。

ユーザーの利便性を大事にするGoogleとしては、当然と言えば当然ですね。

あくまでコンテンツで勝負しましょう。

robotsでよく使われる3つの命令(noindex,nofollow,noarchive)

ページを検索結果に表示させない命令として、主に3つほど使うことがあります。

noindex命令

クローラへの命令の中で、最も使うものと言っていいでしょう。

これを指定することにより、インデックスを拒否することができます。

要は、Googleなどで検索した時の結果に表示しないということです。

検索に引っかからなければ、閲覧される可能性は低いでしょう。

この命令だけでも、十分な場合もあります。

nofollow命令(通知)

nofollowを設定したページから、リンク先をクロールさせないようにする設定です。

ロボットがリンク先を辿らないように通知できます。

ざっくり言えば、リンク先との関係を断つ、というものです。

noindexほど直接的ではありませんが、中途半端な状態で評価されてしまうとマイナスに働く可能性も考えられます。

※昔は、業者が営業目的のリンクを張ることもありました。

noindexで一時的に公開するような場面では、一緒に設定しておくと無難です。

見出しで「通知」としていますが、厳密に言えば2020年頃から命令からヒントへと変更されました。

あくまで補助的な要素になります。

ロボット側で考慮しないこともあることは、頭の片隅にでも入れておきましょう。

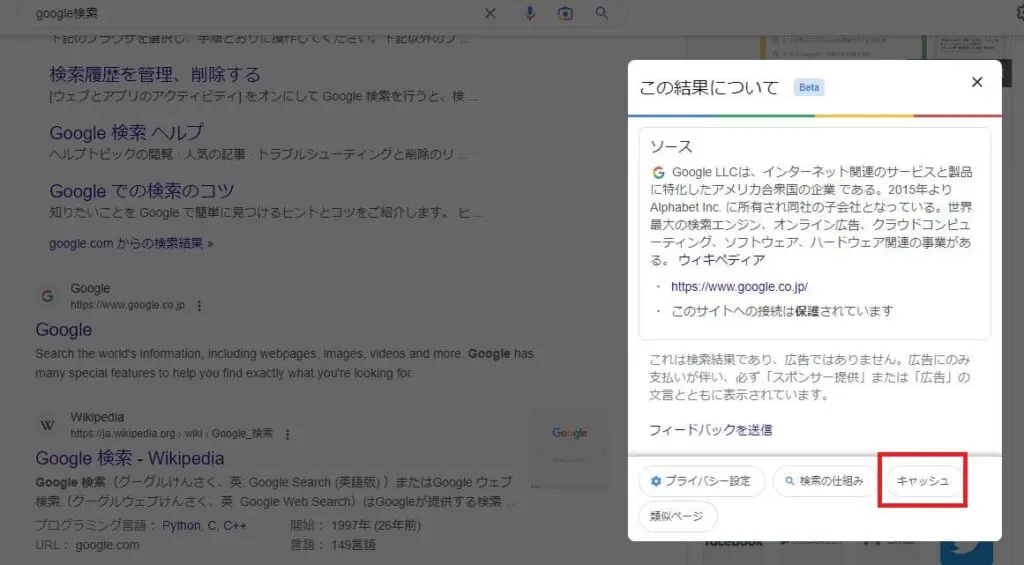

noarchive命令

検索結果にキャッシュリンクを表示しないようにする命令です。

上記はGoogleを例にしたものです。

キャッシュから最後に登録(インデックス)された内容を表示させることができます。

noarchiveを指定すると、このキャッシュに保存をしないよう命令が可能です。

インデックスしていなければ関係ありません。

ですが、未完成のキャッシュを作らないよう設定しておいた方が安心できます。

クローラに命令する2つの方法

metaタグに設定する

ページ単位で設定することができます。

最も使いやすいと言って良い方法です。

特別な理由がなければ、このタグによる設定で良いでしょう。

ちょっとした仮アップや、広告用LPなどにも向いています。

headタグに設定することが基本ですが、body内に記述しても動作します。

したがって、CMSなどで個別投稿に設定することも可能です。

記述例

<head>

<!-- 省略 –>

<meta name=”robots” content=”noindex”>

</head>

HTTPヘッダーに設定する

この方法では、ページ毎にも全体に設定する場合にも向いています。

上で書いたようにページ毎の場合はmetaタグの方が簡単です。

そのため、例えばサイト全体を制御する場合にお勧めです。

サーバーサイドでヘッダーを作ればいいので、記述例ではレスポンスの方を紹介します。

記述例

X-Robots-Tag: noindex

robotsの設定で絶対にやってはいけない4つのこと

非公開情報を含むページを、robotsの設定のみで対処する

robotsの命令は、検索エンジンのロボットに対する設定です。

アクセスを制御するものではありません。

URLさえ分かってしまえば、誰でもアクセスできてしまいます。

公開してはいけない情報がある場合は、下記がおすすめです。

- IP制限

- パスワード保護

- BASIC認証(短期限定)

一時的に閉鎖するページをnoindexにする

再開の予定があるページに対して、noindexを設定することは得策ではありません。

せっかく築いてきたGoogleの評価が、失われてしまう可能性があります。

基本的には、ステータス200を返し続けることをお勧めします。

例えば法律の改定などで内容が大幅更新される場合でも、記事冒頭でそれをテキストで伝えてみましょう。

「ただいま○○年××月の改正▲▲法に基づき、記事の変更を行っています。一部古い情報が表示される可能性があるので、ご注意ください。

間違った情報を与えるリスクを軽減しつつ、SEO評価もそこまで落とすことはないでしょう。

勿論早く対応するに越したことはないので、なるべく早く記事を更新するように心がけてください。

すぐにインデックスから消したいページをnoindexのみで対処する

noindex命令には広義で削除の機能がありますが、根本にあるのはロボットへの命令です。

登録済みのインデックスから削除されるには時間がかかります。

これは、ページ自体を削除して404エラーを返すようにした場合も同じです。

インデックスから消されるまでは、エラーページを返すもののGoogleの検索結果に残ってしまいます。

このような場合には、noindexの設定よりもサーチコンソールでの削除が向いています。

サーチコンソールでインデックスを消す際は、予めページにnoindexを設定しておきましょう。

そのままの状態では、消したとしても再度クローラに検知・登録される可能性があります。

robotsの設定を信用しすぎる

robotsの設定は、クローラに対する命令およびヒントになります。

例えば、個人で作成したスクレイピングツールなどには対応していません。

検索エンジンによっては、無視する可能性もあります。

クローラやツールがそれを採用するかどうかは、ロボットやツールの作成側にかかっているということです。

記事の保護や情報の公開レベルについては、コンテンツの制作者側で主導権を取れるものにしましょう。

robots命令は適用範囲を把握し、万が一公開しても問題ないものに留めよう

今回は、検索結果の一覧に登録させないようにするrobotsの設定について解説しました。

途中記事の仮公開などの用途で重宝します。

ページの保護機能は持っていないため、公開できないデータは必ずアクセスを制御する形で保護しましょう。

URLがばれて情報流出などと”つまらない”結果にならないようにしたいですね。

参考リンク

■Google)Robots meta タグ、data-nosnippet、X-Robots-Tag の設定

https://developers.google.com/search/docs/crawling-indexing/robots-meta-tag

■(Google)Google に外部リンクの関係性を伝える

https://developers.google.com/search/docs/crawling-indexing/qualify-outbound-links?hl=ja